Mit Regelmäßigkeit bekräftigt Google seine Vorgehensweise im Kampf gegen Spammy Websites. Dabei spielen automatische Filter nach wie vor eine sehr wichtige Rolle. Zunehmend geht der Suchriese aber auch mit seinen Mitarbeitern (Googles Quality Rater) persönlich gegen diese Art Seiten vor. Dazu wurde auf der Unternehmensseite kürzlich eine Statistik veröffentlicht, die diese Arbeit über die letzten 10 Jahre (seit August 2004) dokumentiert.

Spam bekämpfende Аlgorithmen

Auf der Suche nach Spam

Am meisten vertreten sind laut Google die s.g. „reiner-Spam“-Projekte mit automatisch generierten Inhalten oder Cloaking. Unter reinen Spam fallen Websites, die folgende Sachlagen und Techniken verwenden:

„Als reine Spammer werden solche Websites bezeichnet, die aggressive Methoden von Spam verwenden, die automatische Links generieren, Cloaking betreiben und fremde Inhalte anderer Websites verwenden. Erfolgen solche Verstöße mehrfach und zielgerichtet, hat das in den meisten Fällen Abwertungen zur Folge. In der letzten Zeit kommt es immer wieder verstärkt zu Abwertungen, die nicht nur mittels Algorithmen detektiert werden, sondern vom Spam-Team persönlich vorgenommen werden.“

Gehackte Websites und „unnatürliche“ Links

Der zweite Platz in Bezug auf handgemachte Abstrafungen geht an die „gehackten Websites“. Das sind die Websites, die, auch ungewollt, Viren und Malware verbreiten.

Passend dazu:

Google erkennt Malware besser, als andere Suchmaschinen

Google möchte Cyberangriffe minimieren

Diese Seite kann ihren Computer beschädigen. Als attackierend gemeldete Webseite

Wir berichteten über folgende Angriffswellen:

Joomla Lücke und der .htaccess redirect Hack

WordPress Projekte durch den neuen JS/iFrame.BO.1 Virus und Parallels Plesk Sicherheitslücke bedroht

WordPress Installationen weltweit unter Angriff

Die Anzahl der Strafen für „unnatürliche Links“, die in den letzten Jahren eine große Aufmerksamkeit seitens Moderatoren an sich gezogen haben, ist sichtbar zurückgegangen.

Algorithmische (nicht-manuelle) Updates

In regelmäßigen Abstanden sorgt Google auch mit algorithmischen Updates für neue Bewertungsansätze für Websites. Updates, wie beispielsweise das Panda-Update (2011, thin Content) oder auch das Penguin-Update (2012, unnatürliche Links), sorgen dafür, dass bestimmte Websites davon profitieren, aber auch Websites abgewertet werden.

Der Fokus bei algorithmischen Updates lag in der letzten Zeit bei Google immer häufiger in der Bekämpfung von unnatürlichen Links. Folgt man den Äußerungen von Matt Cutts, dem Leiter der internen Spam-Abteilung bei Google, wird diese Strategie auch weiterhin im Hause verfolgt werden.

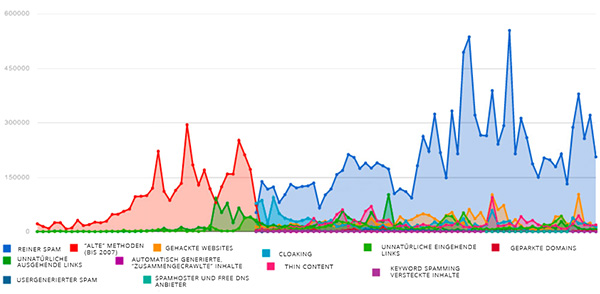

Google Spam-Arten. Quellen: seom. info, Googles Spam-Bekämpfung

Anti-Spam: Arten und der Ablaufplan

Googles Aktionen sind u.A. gegen folgende Spam-Arten / Techniken gerichtet:

- Cloaking

- Gehackte Website

- Verborgene und überflüssige Keywords

- Spam von geparkten Domains

- Aggressive Spam-Techniken im Allgemeinen

- Spam von kostenlosen Hosting-Diensten

- Inhalte von geringer Qualität (thin Content)

- Unnatürliche Links von oder zu einer Website

- Nutzergenerierter Spam (Gästebücher, Blogkommentare)

Im Einzelnen gab es Aktivitätsausbrüche – es ist sehr interessant zu beobachten, wie sich Googles Schwerpunkte in diesem „Spam-War“ seit 2005 verlagert haben:

- Oktober 2009 – Unnatürliche ausgehende Links

- November 2009 – Gehackte Websites

- Februar 2011 – Freehost- und DynDNS-Anbieter, mit dem Schwerpunkt Spam

- Oktober 2011 – Cloaking, geparkte Domains

- April 2012 – Penguin

Antrag auf Überprüfung

Webseitenbetreiber gegen die von Google Sanktionen verhängt wurden und die sich zu Unrecht behandelt fühlen, können bei Google eine Überprüfung beantragen. In diesen Einzelfällen prüfen Mitarbeiter bei Google den Sachverhalt neu.

Lesen Sie unsere Beiträge zu den Themen Malware, Penguin-Update und „Google Reinclusion“:

Malwarefund. Vorgehensweise und Webseitenüberprüfung

Antrag auf Wiederaufnahme in den Index richtig stellen. Googles Reinclusion

Raus aus dem Penguin. Erkannt und behoben

Auf dem dazu gehörigen Diagramm bei Google sind leider keine Termine, sondern nur die Wochen angegeben. Es stellt sich heraus, dass die 43. Woche, also 25. bis 31. Oktober 2010 die meisten Anträge auf Überprüfung bei Google eingegangen sind.

Dieser Ausbruch ist durch die Einführung des neuen Benachrichtigungssystems in Googles Webmaster Tools und den aktiven Versand der s.g. „blauen Briefe“ durch Quality Rater bei Verstößen gegen Googles Webmaster Richtlinien.

Mehr dazu:

Matt Cutts Prognosen für die nahe Zukunft

Elf Arten von Links, die Google nicht mag

Google warnt erneut vor gekauften Artikeln und künstlich erzeugten Backlinks

Wie viele der Googles „reinclusion requests“ von Moderatoren auch akzeptiert und wie viele abgelehnt wurden? Leider gibt Google keine Auskunft dazu.

Wie funktioniert Suchmaschinenoptimierung. SEO-Guide 2023

Wie funktioniert Suchmaschinenoptimierung. SEO-Guide 2023  MUM, der neue Algorithmus von Google

MUM, der neue Algorithmus von Google  Google diskutiert über die Zukunft der Suchmaschinenoptimierung

Google diskutiert über die Zukunft der Suchmaschinenoptimierung  YMYL-Sites: das Vertrauen von Google gewinnen. Eine Checkliste, zwei Cases

YMYL-Sites: das Vertrauen von Google gewinnen. Eine Checkliste, zwei Cases

Hinterlasse als Erster einen Kommentar