Interne doppelte Seiten können zu Fehlern bei der Indexierung der Website führen oder bisheriges gutes Ranking wieder zunichte machen. Deshalb sollte immer mal wieder überprüft werden, ob sich nicht interner Duplicate Content ergeben hat. DC Probleme gibt es überall: in Blogs, Foren, bei fast allen gängigen Content Management oder auch Shop Systemen.

Was ist und wie entsteht Duplicate Content?

Unter internem Duplicate Content bezeichnet man die Situation, wenn auf einer Website mehrere unter verschiedenen URL’s aufrufbare Unterseiten existieren, mit gleichen oder fast gleichen Inhalten.

Man sollte zwischen zwei Fällen unterscheiden: wenn Inhalte 1:1 identisch sind oder wenn sie fast gleich bzw. sehr ähnlich sind.

1. Duplicate Content mit 1:1 gleiche Inhalten

Vielfach sind Seiten mit 1:1 gleichen Inhalten unter unterschiedlichen URL’s einer Website auffindbar. 1:1 gleiche Inhalte entstehen zum Beispiel wenn eine Originalunterseite noch unter einer anderen URL für die Druckversion zugänglich ist, bei Session-ID’s, bei Seiten mit verschiedenen Dateiendungen (*.html, *.php, .*htm).

Die meisten 1:1 DC Unterseiten werden von CMS oder Shop Systemen automatisch generiert, aber es gibt auch Fälle, wo das Problem der Unaufmerksamkeit des Webmasters zu verdanken ist.

Beispielsweise ist das s.g. index.html – Duplicate Content Problem immer noch ein häufig verbreiteter Fall, der eintritt, wenn die Startseite unter http://domain.tld, http://www.domain.tld/ oder http://www.domain.tld/index.html (index.php oder default.aspx etc.) erreichbar ist.

Häufig entsteht Duplicate Content nach einem Redesign, einer Restrukturierung der Website oder einem CMS-Wechsel. Alle neuen Seiten bekommen neue URL’s, unter den alten Adressen bleiben sie aber auch noch erreichbar.

2. Duplicate Content bei Unterseiten mit ähnlichen Inhalten in Galerien, Online Shops und CMS

Das Problem entsteht immer dann, wenn der einzigartige Teil einer Unterseite immer geringer ist, als der sich immer wiederholende Teil. Ein häufiges Beispiel stellen die Unterseiten einer Bildergalerie dar: der unique Teil ist ein Bild (10%), der sich immer wiederholende Teil ist in diesem Beispiel der Rest der Seite (90%).

Probleme mit internem Duplicate Content haben immer wieder auch Online Shops, die Produkt Detailseiten, mit nur kurzen Beschreibungen und ohne Zusatzcontent im Sortiment haben.

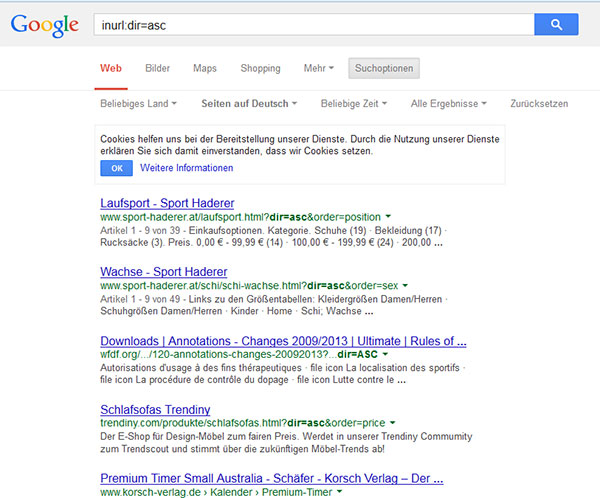

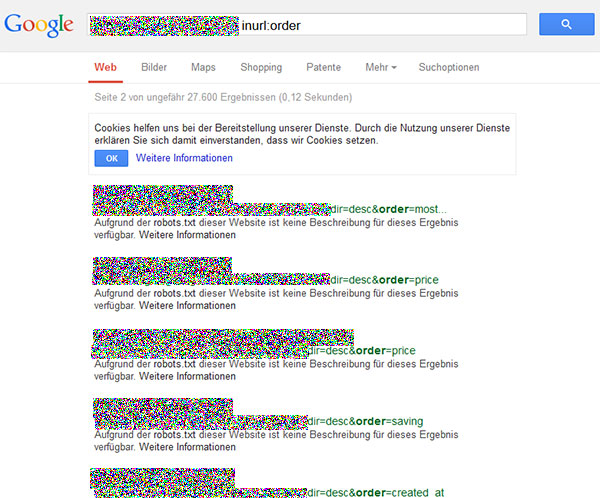

Außerdem werden oftmals gleiche Inhalte in Kategorien geliefert, die lediglich anders sortiert sind (nach Farbe, Größe, Preis, beispielsweise im Shopsystem Magento). Dabei wiederholt sich der Content auf vielen Seiten und nur eine Seitenüberschrift ist verändert.

Duplicate Content in Online Shops durch Sortierung

Duplicate Content in Online Shops durch Sortierung. Indexierung in robots.txt verboten

In Content Management Systemen wie WordPress oder Drupal, die Verschlagwortung (Tagging) unterstützen, sorgen die halbautomatische Tags-Unterseiten, besonders die, die nur einem oder zwei Beiträgen zugeordnet sind für internen Duplicate Content.

Lesen Sie auch:

CMS. Auswahl und Benutzung. Content Management

SEO für Content Management Systeme

WordPress. SEO für WP

SEO Onpage Optimierung

Google Check: Wie kann man feststellen, ob eine Website Duplicate Content enthält?

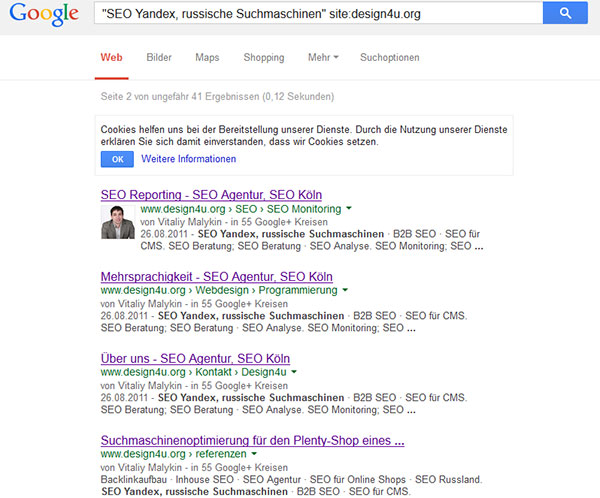

Am einfachsten lässt sich das Vorhandensein von Duplicate Content mit Google prüfen. Dafür gibt man den zu überprüfenden Text oder Satz in Anführungsstrichen bei Google ein, zusammen mit dem site:-Befehl.

Ein Beispiel: „SEO Yandex, russische Suchmaschinen“ site:design4u.org

Duplicate Content Check

Im Ergebnis kann man sehen, dass Google wohl ein Teil des Mega Drop-Down Menüs als Duplicate Content wertet.

Duplicate Content loswerden

Der optimale Weg zur Vermeidung von Duplicate Content hängt davon ab, ob die jeweilige Unterseite im Google-Index bleiben sollte. Ist das nicht der Fall, gibt es viele Möglichkeiten, die Problemstellen aus dem Index zu entfernen.

Disallow in robots.txt

Disallow wird verwendet, um die Indizierung bestimmter Unterseiten den Suchmaschinen zu untersagen oder bereits indexierte Seiten aus der Datenbank zu entfernen. Dies ist die beste Option, um doppelte Inhalte auszuschließen, die sich ausschließlich in bestimmten Verzeichnissen befinden, oder wenn die URL-Struktur es ermöglicht, viele Seiten mit einer Regel zu erfassen.

Zum Beispiel, wenn sich alle internen Suchergebnisse auf der Website im Ordner www.domain.tld/search/ befinden, lautet die Regel für robots.txt einfach

Disallow: / search /Ein weiteres Beispiel. Sollten alle Session-ID’s mit dem Fragezeichen „?“ beginnen, können Sie die Indizierung aller Seiten, die dieses Zeichen beinhalten, folgendermaßen deaktivieren:

Disallow: / *?So kann man grundsätzlich Seiten zur Indexierung verbieten, wie die Druckversionen, Sessions, interne Suchergebnisse etc.

rel = canonical-Tag

Das rel=canonical Tag wird verwendet um dem Suchroboter zu zeigen, welche der Seiten einer bestimmten Gruppe, in den Suchindex darf. Diese Seite wird als kanonisch bezeichnet. Um eine kanonische Seite richtig dem Suchroboter anzugeben, ist es notwendig, alle NICHT-kanonische Seiten mit dem canonical-Tag der kanonischen, wichtigen Seite zu versehen

<link rel="canonical" href="http://domain.tld/kanonische-url.html">rel=canonical eignet sich hervorragend, um Duplicate Content loszuwerden, der sich in einer Ausnahme nicht per robots.txt ausschließen lässt.

301-Redirect

301 Permanent Redirect wird verwendet, um Benutzer sowie auch die Suchroboter von einer Seite zur anderen umzuleiten. Das ist eine optimale Methode, wenn sich die Struktur der Website beispielsweise nach einem CMS-Wechsel verändert hat und die gleichen Inhalte sowohl an der alten als auch an der neuen Stelle erreichbar sind.

Ein Redesign für Design4u 2009

Duplicate Content. Onpage Optimierung

301-Weiterleitung signalisiert dem Crawler, dass die Seite für immer umgezogen ist, was der Übertragung vom Gewicht und der Linkmasse von der alten auf die neue URL in den meisten Fällen hilft. Konfigurieren lässt sich diese Weiterleitung in der .htaccess-Datei durch eine der vielen Regeln wie:

Redirect 301 /category/old-page.html new-page.htmlDie 301-Weiterleitung lässt sich massenhaft, also gleich mit einer Regel auf viele Unterseiten anwenden, aber es ist dann notwendig, dass die Seiten eine einheitliche Struktur haben.

Ihre Kreativität ist gefragt

Es gibt natürlich immer wieder die Art von Dublicate Content, der nützliche Informationen enthält und auf den nicht so einfach verzichtet werden kann und der auch weiterhin indexiert bleiben sollte. Hier hat ein SEO verschiedene Möglichkeiten den Text inhaltlich beizubehalten, aber ihn so zu ergänzen, dass kein Duplicate Content mehr besteht.

Immer gut eignen sich hier Zwischenüberschriften, Texthervorhebungen, Glossare, Fotos, Kundenbewertungen und Zusatzcontent. Viele Onlineshops arbeiten auch mit Kommentarfunktionen oder Produktempfehlungen, die immer wieder verändernd eingefügt werden.

Lesen Sie auch:

Content auf kommerziellen Websites

Usability, SEO und die Umsatzsteigerung im Online Shop

8 Tipps zur Umsatzsteigerung in einem Online Shop

Die Kreativität ist auch dann besonders gefragt, wenn, wie häufig in den Online Shops gleiche Produkte mit den gleichen Beschreibungen in unterschiedlichen Kategorien angezeigt werden.

Angenommen, es gibt einen Online-Shop, der Taschen verkauft, wo die gleichen Produkte in mehreren Kategorien gefunden werden. Als Beispiel kann eine Damentasche mit Henkel aus Leder von Gucci in 4 Kategorien ausgegeben werden: Handtaschen, Ledertaschen, Taschen mit Henkel und Gucci angezeigt werden. Es ist auch nicht falsch, denn diese Tasche gehört wirklich in alle vier Kategorien.

Aber wenn die Produktbeschreibung in all diesen Kategorien vorhanden ist, kann es nicht funktionieren, vor allem, wenn sich viele Produkte und nicht nur diese Tasche überschneiden.

Die Lösung wäre dann entweder keine Produktbeschreibungen auf diesen Seiten anzuzeigen, sie erheblich zu reduzieren (was das Problem nicht komplett lösen wird) oder das Problem kreativ anzugehen und die Beschreibung automatisch, in Abhängigkeit von der Kategorie zu ändern. Beispiel: Stilvolle [Frauen] [Leder] Tasche [Farbe] [Gucci] [mit einem Henkel] [für jeden Tag].

Diese Maßnahmen haben dann nicht nur den Zweck der DC-Vermeidung, sondern wirken sich auch noch verkaufsfördernd aus.

Wie funktioniert Suchmaschinenoptimierung. SEO-Guide 2023

Wie funktioniert Suchmaschinenoptimierung. SEO-Guide 2023  MUM, der neue Algorithmus von Google

MUM, der neue Algorithmus von Google  Happy Landing! Warum sich Landing Pages auch für Onlineshops lohnen

Happy Landing! Warum sich Landing Pages auch für Onlineshops lohnen  34 Fragen an Ihre Zielgruppe für effektive USP’s und Landing Pages

34 Fragen an Ihre Zielgruppe für effektive USP’s und Landing Pages

Hinterlasse als Erster einen Kommentar